Wenn du jemanden anlächelst und er nicht reagiert, wirst du das wahrscheinlich abstoßend finden. Nein? Nun, dieser Roboter würde Ihnen mehr Zufriedenheit bereiten als irgendein Nachbar.

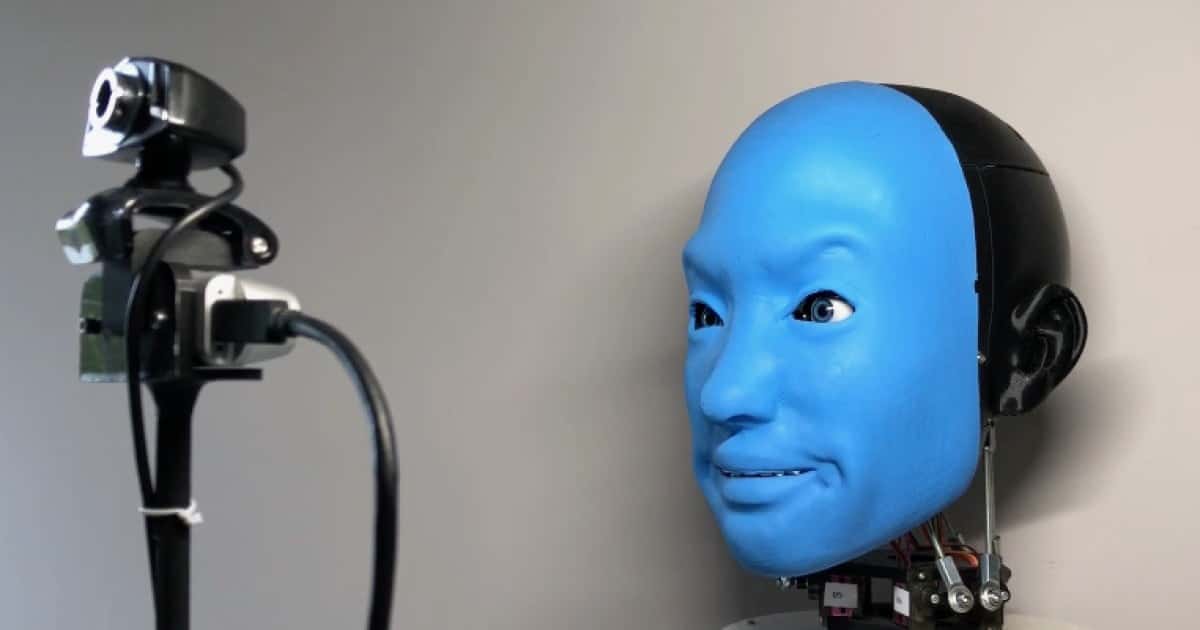

Entwickelt von einem Team von Ingenieurforschern an der Columbia University in New York City. das EVA-Projekt ist eigentlich eine Römische Stirn Humanoide Robotik. Es wurde entwickelt, um die Dynamik der Mensch-Roboter-Interaktion durch Mimik zu erforschen. Es besteht aus einem 3D-gedruckten, synthetischen Totenkopf für Erwachsene mit einem weichen Gummigesicht auf der Vorderseite.

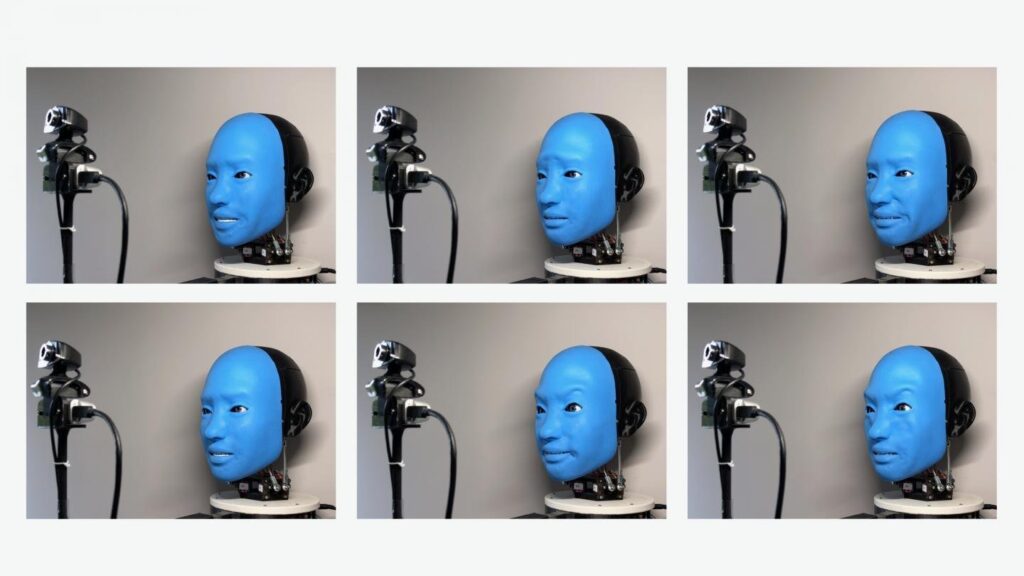

Motoren innerhalb des Schädels ziehen und lösen selektiv Kabel, die an verschiedenen Stellen der unteren Gesichtshälfte angebracht sind, genauso wie die Muskeln unter der Haut unseres Gesichts es uns ermöglichen, verschiedene Gesichtsausdrücke zu zeigen. EVA seinerseits kann Emotionen wie Wut, Ekel, Angst, Freude, Traurigkeit und Überraschung sowie "eine differenziertere Reihe von Emotionen" ausdrücken.

Ein Roboter, der unsere Mimik nachahmt

Um ihre Fähigkeit zu entwickeln, Gesichtsausdrücke nachzuahmen, begannen Wissenschaftler, das EVA zu filmen, während sie beiläufig ihr Gesicht bewegte. Als der Computer, der den Roboter steuerte, anschließend die Drehstunden analysierte, lernte er über ein integriertes neuronales Netz, welche Kombinationen von „Muskelbewegungen“ zu menschlichen Gesichtsausdrücken passten.

In der zweiten Phase des „Trainings“, in der eine angeschlossene Kamera das Gesicht einer mit dem Roboter interagierenden Person erfasst, a Seconda neuronales Netzwerk, um die Gesichtsausdrücke dieser Person zu identifizieren und sie visuell mit denen abzugleichen, die der Roboter erzeugen konnte. Der Roboter nahm dann diese "Gesichter" an, indem er seine künstlichen Gesichtsmuskeln bewegte.

Ist nützlich?

Obwohl Ingenieure zugeben, dass die einfache Nachahmung menschlicher Gesichtsausdrücke nur begrenzte Anwendungsmöglichkeiten hat, glauben sie, dass dies dennoch nützlich sein könnte. Es ist kein Zufall, dass so viele Workshops sind am Arbeiten zur Reproduktion von Gesichtsausdrücken. Es könnte beispielsweise dazu beitragen, die Art und Weise, wie wir mit assistiven Technologien interagieren, voranzutreiben.

„Es gibt eine Grenze, wie viel wir Menschen emotional mit Cloud-basierten Chatbots oder Sprachassistenten interagieren können“, sagt Projektleiter Prof. Hod Lipson. "Unser Gehirn scheint gut auf Roboter zu reagieren, die eine erkennbare physische Präsenz haben."

Sagen Sie mir nicht, dass die nächste Generation von Google Nest oder Alexa ein Kopf mit mir reden wird, weil ich mich ausziehe. Ich gehe, nicht wahr?

Sie können in diesem Video sehen, wie EVA Gesichtsausdrücke nachahmt.