In einer hellen Umgebung voller Monitore und technischer Ausrüstung steht ein Roboter als Protagonist. Seine Metallstruktur reflektiert Licht, aber in seinen „Augen“ verbirgt sich die wahre Magie. Diese Augen, angetrieben durch das RT-2-Modell von DeepMind, sind in der Lage zu sehen, zu interpretieren und zu handeln.

Während sich der Roboter anmutig bewegt, prüfen die Wissenschaftler um ihn herum jede seiner Bewegungen. Es ist nicht nur ein Stück Metall und ein Schaltkreis, sondern die Verkörperung einer Intelligenz, die die weite Welt des Internets mit der greifbaren Realität verbindet.

Die Entwicklung von RT-2

Die Robotik hat in den letzten Jahren große Fortschritte gemacht, aber DeepMind Es hat das Spiel einfach auf ein ganz neues Level gehoben. Illustriert in einem Papier Gerade veröffentlicht, ist es angekommen RT-2. Dinge? Es handelt sich um ein Vision-Language-Action (VLA)-Modell, das nicht nur aus Webdaten, sondern auch aus Roboterdaten lernt und dieses Wissen in verallgemeinerte Anweisungen für die Robotersteuerung übersetzt.

In einer Zeit, in der die Technologie sprunghaft voranschreitet, stellt der RT-2 einen bedeutenden Sprung dar und verspricht, nicht nur den Bereich der Robotik, sondern auch die Art und Weise, wie wir jeden Tag leben und arbeiten, zu revolutionieren. Doch was bedeutet das in der Praxis?

DeepMind RT-2, von der Vision zur Tat

Die Modelle von High Capacity Vision-Language (VLM) Sie werden auf große Datenmengen trainiert und sind dadurch auch außerordentlich gut darin, visuelle oder sprachliche Muster zu erkennen (z. B. in verschiedenen Sprachen). Aber stellen Sie sich vor, Sie könnten Roboter dazu bringen, das zu tun, was diese Modelle tun. Hören Sie auf, sich das vorzustellen: DeepMind macht es mit RT-2 möglich.

Robotertransformatoren 1 (RT-1) Es war an sich schon ein Wunder, aber RT-2 geht noch weiter und zeigt verbesserte Generalisierungsfähigkeiten sowie ein semantisches und visuelles Verständnis, das über die Roboterdaten hinausgeht, denen es ausgesetzt war.

Kettenargumentation

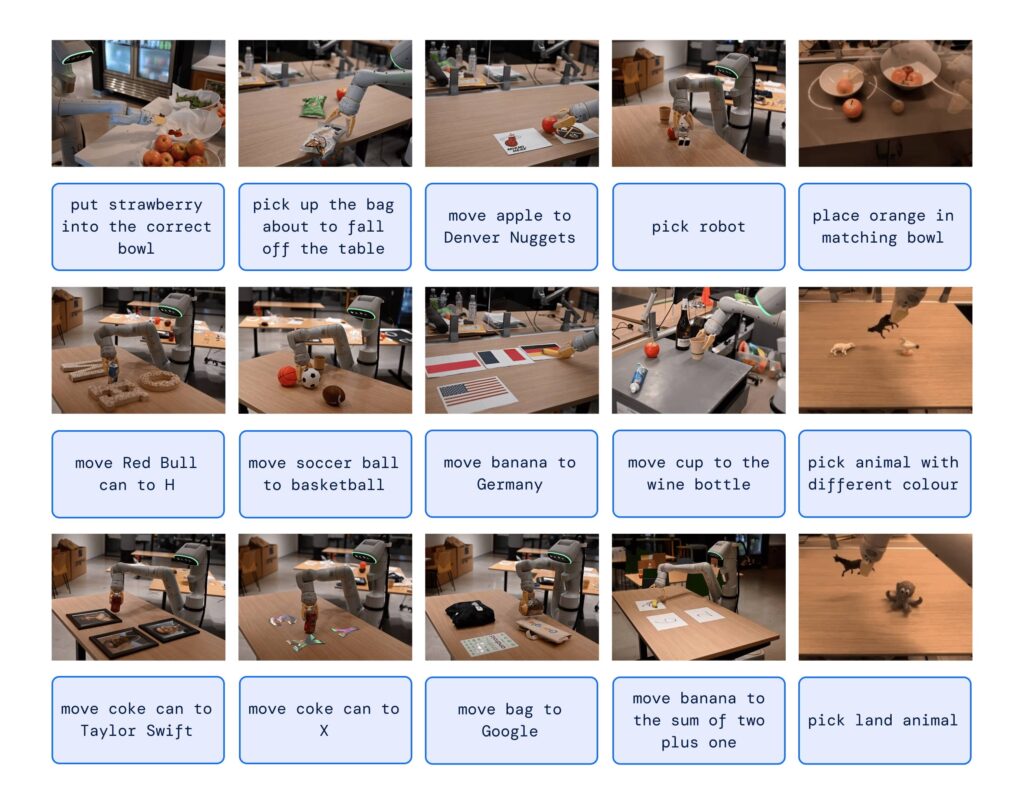

Einer der faszinierendsten Aspekte von RT-2 ist seine Fähigkeit zum Kettenschluss. Er kann entscheiden, welcher Gegenstand als Behelfshammer verwendet werden kann oder welches Getränk für einen müden Menschen am besten geeignet ist. Diese Fähigkeit zum tiefen Denken könnte die Art und Weise, wie wir mit Robotern interagieren, revolutionieren.

Und das Schlimmste: Sie könnten immer noch einen Roboter bitten, Ihnen einen guten Kaffee zu kochen, um wieder etwas Klarheit zu gewinnen.

Doch wie steuert DeepMind RT-2 einen Roboter?

Die Antwort liegt in der Art und Weise, wie er ausgebildet wurde. Tatsächlich verwendet es eine Darstellung, die den Sprachtokens nicht unähnlich ist, die von Vorlagen wie ChatGPT ausgenutzt werden.

RT-2 demonstrierte erstaunliche Emerging-Fähigkeiten wie Symbolverständnis, Argumentation und Menschenerkennung. Fähigkeiten, die derzeit eine Verbesserung um mehr als das Dreifache im Vergleich zu Vorgängermodellen aufweisen.

Mit RT-2, DeepMind nicht nur gezeigt, dass Vision-Sprach-Modelle in leistungsstarke Vision-Sprach-Aktions-Modelle umgewandelt werden können, sondern es öffnete auch die Tür zu einer Zukunft, in der Roboter schlussfolgern, Probleme lösen und Informationen interpretieren können, um eine breite Palette von Aufgaben in der Realität auszuführen Welt.

Und nun?

In einer Welt, in der künstliche Intelligenz und Robotik immer wichtiger werden, zeigt uns RT-2, dass die nächste Entwicklung nicht rein technisch, sondern „wahrnehmungsbezogen“ sein wird. Maschinen werden unsere Bedürfnisse auf eine Weise verstehen und darauf reagieren, wie wir es uns nie hätten vorstellen können.

Wenn das erst der Anfang ist, wer weiß, was die Zukunft bringt.