Forschern der Stanford University ist ein bedeutender Durchbruch bei der Entwicklung von gelungen Gehirn-Computer-Schnittstellen (BCI). Durch die Entwicklung einer Technologie, die gesprochene Sprache mit einer Geschwindigkeit von bis zu 62 Wörtern pro Minute entschlüsseln kann, verbesserte das Team den bisherigen Rekord um fast das 3-fache.

Eine Entwicklung, die diese Systeme dem Rhythmus eines natürlichen Gesprächs und einer praktisch sofortigen Sprachumwandlung ein Stück näher bringt.

Bewährung, Bewährung, Bewährung

Der Mitbegründer von Neuralink zusammen mit Elon Musk, Max Hodak, nannte die Stanford-Forschung „eine bedeutende Veränderung im Nutzen von Gehirn-Computer-Implantaten“. Doch woraus besteht es genau?

Der Kern aller Arbeit, detailliert in einem Papier, das ich hier verlinkeist die Fähigkeit, Gehirnsignale mithilfe eines maschinellen Lernalgorithmus in kohärente Sprache zu „übersetzen“. Und zwar durch die Analyse der Gehirnaktivität in einer relativ kleinen Region des Kortex.

Das Ziel? Wir helfen Menschen, die aufgrund von Krankheiten wie ALS nicht mehr sprechen können, ihre Stimme wiederzuerlangen. Ein echter Qualitätssprung: Eine solche Sprachschnittstelle könnte die Dekodierung von Gehirnsignalen deutlich beschleunigen.

Die Tests

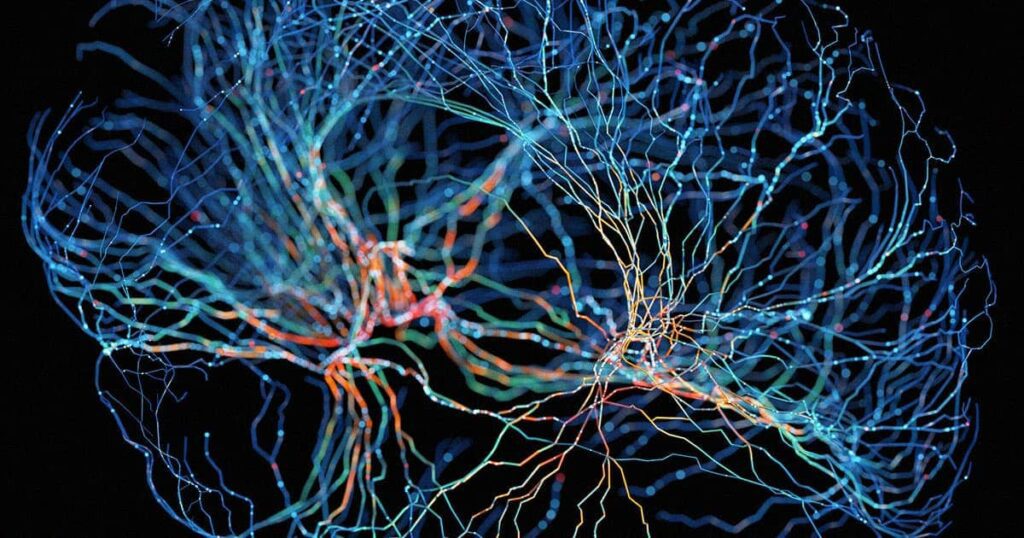

In einem Experiment zeichnete das Team (aus zwei kleinen Bereichen des Gehirns) die neuronale Aktivität eines ALS-Patienten auf, der seinen Mund bewegen kann, aber Schwierigkeiten hat, Wörter zu bilden.

Unter Verwendung eines rekurrenten neuronalen Netzdecoders, der Text vorhersagen kann, wandelten die Forscher diese Hinweise dann in Wörter um. Worte, die in einem Tempo gehen, das noch nie zuvor gesehen wurde.

Es wurde festgestellt, dass die Analyse von Gesichtsbewegungen und den damit verbundenen neuronalen Aktivitäten trotz der Lähmung und begrenzten Ausdehnung der Großhirnrinde stark genug ist, um ein Gehirn-Computer-Schnittstellensystem zu unterstützen.

Die Herausforderungen, denen man sich stellen muss

Derzeit ist das System schnell, aber noch unvollkommen: die Fehlerrate des von den Forschern verwendeten Dekoders für rekurrente neuronale Netze (RNN). es sind immer noch 20%.

Die Forscher wissen das gut: „Unsere Demonstration“, schreiben sie, „ist ein Beweis dafür, dass die Dekodierung versuchter Sprachbewegungen aus intrakortikalen Aufzeichnungen ein vielversprechender Ansatz ist, auch wenn es sich noch nicht um ein vollständiges, klinisch brauchbares System handelt.“

Um die Fehlerquote zu verbessern und den Algorithmus zu optimieren, zielen die Studien nun darauf ab, weitere Bereiche des Gehirns zu untersuchen.

Stellen Sie sich solche Technologien in Kombination mit künstlicher Intelligenz vor. Algorithmen, die in der Lage sind, eine Stimme perfekt zu klonen, wie z die kürzlich von Microsoft vorgestellte was nur 3 Sekunden Audio dauert.

In Zukunft wird niemand mehr schweigen.