Es scheint eine Zukunft zu geben, in der Gedanken nicht länger nur flüchtige Bilder in unserem Kopf sind, sondern zu erstklassigen Videos werden können. Und es scheint eine Zukunft zu sein, die der Realität immer näher kommt. Eine Gruppe erfahrener Forscher hat gerade die Büchse der Pandora auf dem Gebiet der Neurowissenschaften geöffnet. Um ihm zu helfen, eine gute Portion KI.

Das „Projektor“-Gehirn

Jiaxin Qing, Zijiao Chen e Juan Helen Zhou, von der National University of Singapore und der Chinese University of Hong Kong, präsentierte einige recht interessante Forschungsarbeiten. Das Team kombinierte Daten aus der funktionellen Magnetresonanztomographie (fMRT) mit generativer künstlicher Intelligenz mit stabiler Diffusion, um zu erstellen MinD-Video, ein Modell, das HQ-Videos direkt aus Gehirnmessungen generieren kann.

Science-Fiction-Zeug könnte man sagen: aber nein, alles rigoros dokumentiert auf arXiv, z.B Das ist der Link.

Wie genau funktioniert MinD-Video?

MinD-Video ist kein einfacher Videogenerator, sondern ein ganzes System, das darauf ausgelegt ist, die von einer KI durchgeführte Dekodierung von Bildern mit der von einem Gehirn durchgeführten Dekodierung zu kommunizieren. Doch wie trainiert man ein solches System?

Die Forscher verwendeten einen öffentlichen Datensatz, der Videos und zugehörige fMRT-Messwerte von Probanden enthielt, die sie sahen. Und offenbar hat die Arbeit hervorragend geklappt.

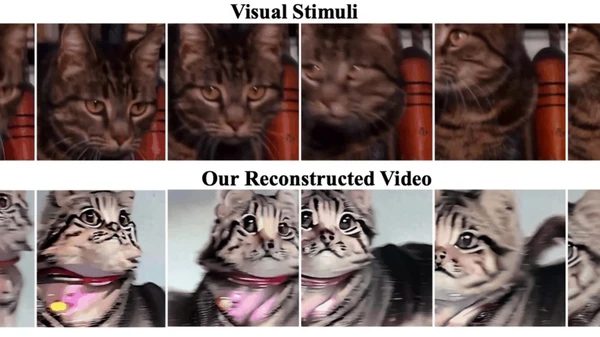

Siehe Gedanken, wir haben es geschafft

Die von Wissenschaftlern veröffentlichten Videos zeigen wirklich faszinierende Ergebnisse. Nehmen Sie zum Beispiel ein Originalvideo mit Pferden auf einem Feld. MinD-Video hat es „neu aufgebaut“, indem es eine lebendigere Version der Pferde erstellt hat. In einem anderen Fall fährt ein Auto durch ein Waldgebiet und das rekonstruierte Video zeigt eine Fahrt aus der Ich-Perspektive entlang einer kurvenreichen Straße.

Den Forschern zufolge seien die rekonstruierten Videos von „hoher Qualität“, mit klar definierten Bewegungen und Szenendynamiken. Und die Präzision? 85 %, eine deutliche Verbesserung gegenüber dem bisherige Versuche.

Gedankenlesen und HQ-Video, was kommt als nächstes?

„Die Zukunft ist rosig und die potenziellen Anwendungen sind immens. Von der Neurowissenschaft bis Gehirn-Computer-Schnittstellen„Wir glauben, dass unsere Arbeit einen wichtigen Einfluss haben kann“, erklärten die Autoren. Und damit nicht genug: Ihre Arbeit verdeutlichte die dominierende Rolle des visuellen Kortex bei der visuellen Wahrnehmung und die Fähigkeit ihres Modells, während des Trainings immer anspruchsvollere Informationen zu lernen.

Das in dieser neuen Forschung verwendete Modell der stabilen Diffusion macht die Visualisierung präziser. „Ein entscheidender Vorteil unseres Modells gegenüber anderen generativen Modellen wie le GANist die Möglichkeit, Videos in höherer Qualität zu produzieren. „Es nutzt die vom fMRI-Encoder gelernten Darstellungen und nutzt seinen einzigartigen Diffusionsprozess, um HQ-Videos zu generieren, die besser mit den ursprünglichen neuronalen Aktivitäten übereinstimmen“, erklärten die Forscher.

Kurz gesagt, es scheint, dass wir wirklich in die Ära eingetreten sind Gedankenlesen durch künstliche Intelligenz. Ein Feld, das tausend Möglichkeiten bietet und dessen Grenzen nur die Vorstellungskraft zu sein scheint.